یک مثال آن، تصویرهای تولیدشده با هوش مصنوعی از انفجاری در پنتاگون (وزارت دفاع ایالات متحده آمریکا) است که در ماه مه در رسانههای اجتماعی به گستردگی پخش شد و تصویرهای پاپ فرانسیس، رهبر کاتولیکهای جهان، در حالی که یک کاپشن پفی پوشیده بود در رسانههای اجتماعی دست به دست شدند. در جریان انتخابات ریاستجمهوری سال جاری (۲۰۲۳ ) در نیجریه، یک فایل صوتی دستکاری شده که در آن ادعا شده بود آتیکو ابوبکر۲، نامزد انتخابات، معاونش دکتر ایفینی اوکووا و امینو تمبووال فرماندار ایالت سوکوتو به دنبال تقلب در انتخابات هستند، در فضای مجازی انتشار یافت.

سایلس جاناتان محقق طرح راستیآزمایی “دوباوا” و یکی از اعضای آکادمی آفریقا برای تحقیقات [با بهره از] منابع آزاد میگوید که جعل عمیق بدون شک سؤالها و نگرانیهای مهمی را برای رسانهها به وجود آورده است. جفری نیابور خبرنگار غنایی که با در زمینه راستیآزمایی کار میکند، بر این باور است که هرچه عاملان انتشار اطلاعات نادرست در استفاده از جعل عمیق موفقتر شوند، به همان اندازه رسانهها اعتبار بیشتری از دست میدهند، چون توان مخاطبان برای تشخیص واقعیت از غیر آن کمتر خواهد شد. با این همه، هوش مصنوعی که خودش یک مشکل است، میتواند راه حل نیز باشد. در این مطلب چند ابزار را که خبرنگاران میتوانند از آنها برای مقابله با جعل عمیق استفاده کنند، معرفی کردهایم.

شبکههای عصبی عمیق

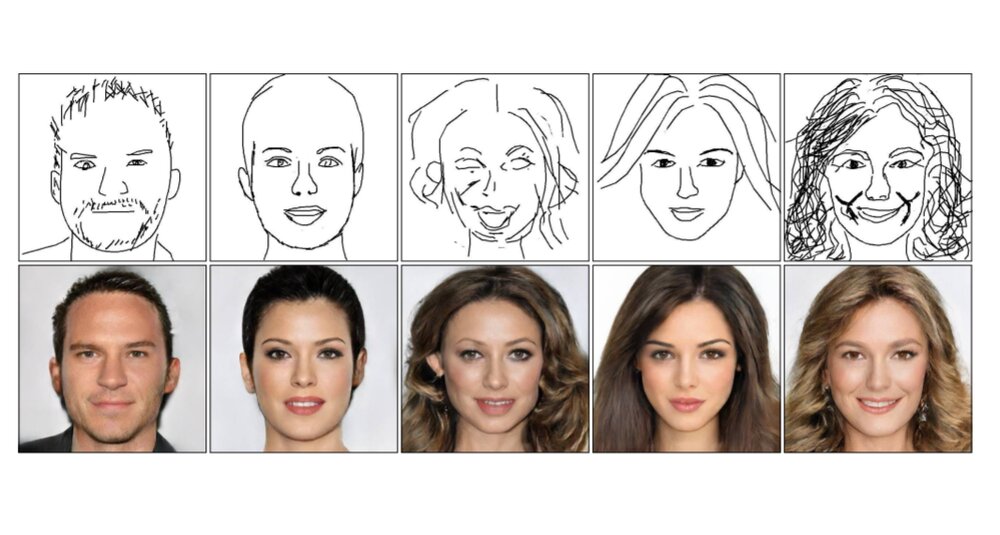

دو نمونه از ابزارهای رایگانی که از شبکههای عمیق نورال (پایانه به پایانه) برای تشخیص جعل عمیق استفاده میکنند، TensorFlow و PyTorch هستند. از آنها میتوان برای تجزیه و تحلیل تصویرها، ویدیوها و فایلهای صوتی استفاده کرد تا نشانههای دستکاری در آنها تشخیص داده شود. کاربران تنها با بارگذاری نمونههای اصلی و جعلی مواد رسانهای (تصویر، ویدیو…) میتوانند به مدل تشخیصدهنده یاد بدهند که آنها را از هم تفکیک کند. به گفته جاناتان «این شبکهها میتوانند از حجم وسیعی از اطلاعات آموزش بگیرند تا از هم گسیختگیها در حالات چهره، حرکات و نمونههای کلامی را تشخیص دهند و در نتیجه به وجود جعل عمیق پی ببرند.» وی میافزاید: «الگوریتمهای آموزش ماشینی هم قابلیت آموزش تجزیه و تحلیل و تشخیص نمونهها را در ویدیو و تصویر دارند تا تشخیص دهند که آیا این نمونهها دستکاری شده و یا با فنون جعل عمیق تولید شدهاند یا نه.»

Deepware

Deepware یک فنآوری منبع باز است که اساساً برای تشخیص ویدیوهای تولیدشده با هوش مصنوعی به کار میرود. این وبسایت یک اسکنر دارد که میتوان ویدیوها را در آن آپلود یا بارگذاری کرد تا تشخیص دستکاری احتمالی میسر شود. الگوهای این ابزار هم مانند ابزارهای دیگر تشخیص جعل عمیق، به دنبال نشانههای دستکاری در چهره انسان میگردند. محدودیت اصلی این ابزار، عدم توانایی آن برای تشخیص تکنیکهای تغییر صداست که نسبت به تغییر چهره، خطر بزرگتری است. مایووا تیجانی از سردبیران ارشد نشریه TheCable، میگوید: «نتیجه کار با Deepware همیشه درست نیست و گاهی هم نتیجه نادرستی به دست میآید. این به میزان خوب بودن جعل، زبان مورد استفاده در آن و چند عامل دیگر بستگی دارد.»

Sensity

Sensity، ابزاری تخصصی برای تشخیص جعل عمیق و شناختن تصویرهای تولیدشده با هوش مصنوعی است. مدلهای یادگیری ماشینی آن میتواند برای تجزیه و تحلیل نشانههای بصری و متنی با هدف تشخیص تصویرهای تولیدشده با هوش مصنوعی استفاده شود. اما این ابزار رایگان نیست. بهای آن بر اساس میزان استفاده ماهانه و علایق شخصی کاربران تعیین میشود.

Hive

با این ابزار، راستیآزمایان مستقل و کاربران اینترنت میتوانند با سرعت متنها و تصویرهای دیجیتال را اِسکَن کنند تا اصالت آنها را دریابند. برای تشخیص دادن اصالت یک تصویر، کاربران میتوانند فایل را در صفحه تشخیص محتوای تولیدشده با هوش مصنوعی این ابزار بارگذاری کنند تا با سرعت پردازش شود. Hive یک extension (اکستنشن یا افزونه) مختص گوگل کروم هم دارد که میتوان آن را به کامپیوتر اضافه کرد.

Illuminarty

Illuminarty هم قابلیت تشخیص تصویر و متن تولیدشده با هوش مصنوعی را دارد. نسخه رایگان آن شامل خدمات ابتدایی است و نسخه غیررایگان آن قابلیتهای بیشتری ارائه میدهد. کاربران میتوانند با این ابزار، قسمت دستکاری شده در یک تصویر را، و این را که آن قسمت با کدام مدل هوش مصنوعی تهیه شده است، دریابند. این ابزار همچنین میتواند بررسی کند که چه قدر امکان دارد یک تصویر با هوش مصنوعی ساخته شده باشد. تمام این ابزارها میتوانند به کاربران کمک کنند تا جعل عمیق را تشخیص دهند و با آن مقابله کنند، اما حتی این همه، همیشه نتیجه درستی به دست نمیدهد. به گفته جاناتان، همیشه خطر نتیجهگیریهای نادرستِ مثبت و یا منفی وجود دارد. یعنی ممکن است محتوای اصلی، به اشتباه به عنوان جعل عمیق شناخته شود، و برعکس.

خبرنگاران و راستیآزمایان مستقل همچنین میتوانند با بررسی نقادانه محتوا، جعل عمیق را تشخیص دهند. تمام تصویرها و ویدیوهای تولیدشده با هوش مصنوعی عاری از عیب نیستند. با نگاه دقیق به بسیاری از آنها، میتوان از ماهیتشان آگاه شد.

۱- Deep fake

۲- Atiku Abubakar

*عکس آرشیوی

انتهای پیام/ علیرضا خوش طینت/ منبع: شبکه بین المللی روزنامه نگاران